Análisis de confiabilidad y de validez

del instrumento Course Experience Questionnaire (CEQ)

Analysis of the Reliability and Validity of the

Course Experience Questionnaire (CEQ)

Análise de confiabilidade e de validade do instrumento

Course Experience Questionnaire (CEQ)

Recepción: 2011-09-09

Aprobación: 2012-02-26

Carlos González

Pontificia Universidad Católica de Chile. Chile. cgonzalu@uc.cl

Helena Montenegro

Universidad de Valparaíso Chile. Chile. helena.montenegro@uv.cl

Lorena López

Universidad de Santiago Chile. Chile. lorena.lopez@usach.cl

|

Resumen El objetivo de este estudio es analizar la validez del instrumento Course Experience Questionnaire (CEQ), empleado para conocer la percepción de los estudiantes sobre la calidad del aprendizaje en la educación superior. El cuestionario fue traducido y aplicado a 325 estudiantes de ingeniería de una universidad pública de la región metropolitana de Chile. Se generaron estadísticas descriptivas y tanto los niveles de confiabilidad como los análisis de validez mostraron resultados mayoritariamente adecuados. El instrumento CEQ puede emplearse para medir la calidad de la docencia en universidades latinoamericanas y se sugiere su uso con fines de investigación. Nuevas investigaciones deberán continuar el proceso de validación e incorporar otras variables consideradas clave por la línea Student Learning Research para indagar la experiencia de aprendizaje de los estudiantes universitarios. Palabras clave Docencia universitaria, contexto de aprendizaje, educación superior, evaluación del docente, estudiante universitario. (Fuente: Tesauro de la Unesco). |

Abstract The objective of this study is to analyze the validity of the Course Experience Questionnaire (CEQ) used to know how students perceive the quality of learning in higher education. The CEQ was translated into Spanish and applied to 325 engineering students at a public university in a metropolitan area of Chile. Descriptive statistics were compiled and the analysis of both reliability and validity showed mostly adequate results. The CEQ can be applied to measure the quality of teaching at Latin American universities and the suggestion is that it be used for research purposes. New studies should continue to validate this tool and to include other variables regarded as crucial in "student learning research" to investigate the learning experience of college students. Keywords College teaching, learning context, higher education, teacher evaluation, college student. (Source: Unesco Thesaurus). |

Resumo O objetivo deste estudo é analisar a validade do instrumento Course Experience Questionnaire (CEQ), empregado para conhecer a percepção dos estudantes sobre a qualidade da aprendizagem na educação superior. O questionário foi traduzido e aplicado com 325 estudantes de engenharia de uma universidade pública da região metropolitana do Chile. Geraram-se estatísticas descritivas e tanto os níveis de confiabilidade quanto as análises de validade mostraram resultados majoritariamente adequados. O instrumento CEQ pode empregar-se para medir a qualidade da docência em universidades latino-americanas e se sugere seu uso com fins de pesquisa. Novas pesquisas deverão continuar o processo de validade e incorporar outras variáveis consideradas chave pela linha Student Learning Research para indagar a experiência de aprendizagem dos estudantes universitários. Palavras-chave Docência universitária, contexto de aprendizagem, educação superior, avaliação do docente, estudante universitário. (Fonte: Tesauro da Unesco). |

Para citar este artículo / To reference this article / Para citar este artigo

González, C., López L., Montenegro, H. (2012) Análisis de confiabilidad y de validez del instrumento Course Experience Questionnaire (CEQ). Educ. Educ. Vol. 15, No. 1, 63-78.

Introducción

Desarrollo y aplicaciones del Course Experience Questionnaire (CEQ)

Obtener retroalimentación sobre las experiencias de aprendizaje de los estudiantes es considerado beneficioso para los profesores y responsables de la docencia al interior de las universidades, pues permite 1) generar información sobre la efectividad de la enseñanza de los profesores, 2) entregar información para la toma de decisiones respecto de la docencia y 3) obtener datos para ser usados en investigación sobre los procesos de enseñanza. Por otro lado, esta información también puede usarse como evidencia en procesos de aseguramiento de la calidad y benchmarking con otras instituciones (Richardson, 2009).

Un instrumento típicamente usado con estos fines es el Course Experience Questionnaire (CEQ). Este se originó con el trabajo de Ramsden (1991; 1981), en el contexto de una línea de investigación conocida como Student Learning Research (Biggs & Tang, 2007; Entwistle, 2007; Michael Prosser & Trigwell, 1999). Esta línea se ha desarrollado a lo largo de aproximadamente treinta años y ha entregado importantes resultados sobre el aprendizaje y la docencia a nivel universitario. Hallazgos clave son los siguientes:

Los estudiantes abordan su aprendizaje de manera superficial o lo hacen de manera profunda. Abordar el aprendizaje de manera profunda implica que los estudiantes están enfocados en el significado de lo que se desea aprender, relacionan lo que están aprendiendo con sus conocimientos previos y tienden a integrar la teoría con la práctica. De este modo perciben y organizan el contenido en un todo coherente y consideran la tarea que enfrentan como una actividad personal para mejorar su conocimiento. Por el contrario, abordar el aprendizaje de manera superficial significa que los estudiantes están enfocados en elementos 'externos' del contenido (por ejemplo, una fórmula matemática o una definición) que se deben memorizar para las evaluaciones formales. De este modo asocian conceptos y datos de manera irreflexiva, sin integrarlos ni comprenderlos, y perciben la tarea como una imposición externa (Marton & Saljo, 2005).

Los profesores abordan su docencia centrándose en lo que ellos hacen y el contenido o en el aprendizaje y el estudiante. Abordar la docencia centrándose en el profesor implica que el foco está en las estrategias y el contenido transmitido por la persona que enseña. En este caso, la clase y el texto son los principales medios de enseñanza. Por el contrario, abordar la docencia centrándose en el estudiante implica que el foco está en quien aprende, en sus procesos de aprendizaje y en la comprensión que se genera sobre el contenido del curso. En este caso, además del uso de clases y textos, se realizan actividades que generen acciones de aprendizaje activo por parte de los alumnos, tales como discusiones, revisión de pares, trabajos de campo, entre otros (Kember, 1997; Postareff & Lindblom-Ylšnne, 2008; M. Prosser & Trigwell, 2006).

Los estudiantes que abordan el aprendizaje de manera profunda tienden a presentar concepciones sofisticadas y percepciones positivas sobre el contexto. Además, estos estudiantes son los que tienen mayor probabilidad de obtener mejores resultados académicos. Por el contrario, los estudiantes que abordan el aprendizaje de manera superficial tienden a presentar concepciones fragmentadas y percepciones negativas sobre el contexto de aprendizaje. Además, son los que tienden a obtener peores resultados académicos (véase por ejemplo, Diseth, 2007; Ellis, Goodyear, Brillant & Prosser, 2008; Ellis, Goodyear, Calvo & Prosser, 2008; Kreber, 2003; Lingard, Minasian-Batmanian, Vella, Cathers, & González, 2009; Minasian-Batmanian, Lingard & Prosser, 2006; Richardson, 2005b; Trigwell & Ashwin, 2006).

El aprendizaje no está determinado por "rasgos" de los estudiantes, sino que la forma en que abordan sus actividades académicas responde a cómo perciben elementos clave de la situación de aprendizaje en que se encuentran (P. Ginns & Ellis, 2009; Paul Ramsden, 2003; Webster, Chan, Prosser, & Watkins, 2009) . Por ejemplo, en un curso determinado, un estudiante que percibe que la evaluación está centrada en la memorización podría tender a abordar su aprendizaje de manera superficial para "cumplir" con las pruebas que se le presentan. Sin embargo, el mismo estudiante podría abordar su aprendizaje de manera profunda en un curso donde perciba, por ejemplo, una docencia y evaluación apropiadas.

De manera muy importante se ha establecido que cuando los profesores enseñan centrándose en el aprendizaje, los estudiantes tienden a abordarlo de manera profunda y a obtener mejores resultados académicos (Trigwell, Prosser, & Waterhouse, 1999). Esto ha llevado a generar un alto grado de consenso respecto a que abordar la enseñanza centrándose en el aprendizaje y en los estudiantes debería ser incentivado; y a que abordarla centrándose en el contenido y en el profesor debería ser desincentivado (Paul Ginns, Kitay & Prosser, 2008; González, 2010; 2011).

En un principio el CEQ se pensó como un indicador de la calidad de la docencia. Se realizaron auspiciosos estudios preliminares que desembocaron en una evaluación que se les hizo a 3371 estudiantes de último año provenientes de 13 instituciones de educación superior en Australia. El instrumento testeado consistía de 30 ítems agrupados en cinco escalas: "buena docencia", "metas y objetivos claros", "carga de trabajo apropiada", "evaluación apropiada" y "énfasis en independencia" (Ramsden, 1991). Estas dimensiones son las que tradicionalmente se evalúan, en los estudios asociados a esta línea de investigación, como parte de la percepción que los estudiantes tienen sobre el contexto. Los resultados de esta evaluación indicaron que el instrumento tenía niveles apropiados de validez y confiabilidad. Con base en esto, desde 1993 la evaluación se aplica anualmente como parte de la Encuesta de Destino de Graduados, que debe responder todo nuevo graduado de instituciones de educación superior en Australia. Originalmente, usar la percepción de los estudiantes como una medida de la calidad de la experiencia de aprendizaje y docencia fue resistida por las comunidades académicas. Sin embargo, la robustez de los resultados obtenidos por la línea de investigación Student Learning Research logró generar un consenso respecto a la importancia de esta medición (Wilson, Lizzio, & Ramsden, 1997). La discusión se centró entonces en que el cuestionario consideraba atributos puramente académicos y dejaba de lado elementos como el apoyo institucional a los estudiantes, los recursos para el aprendizaje, etc., y por eso se realizó un trabajo de mayor desarrollo con el CEQ.

En el 2001, McInnis, Griffin, James y Coates (2001) diseñaron y testearon nuevas escalas: "apoyo a los estudiantes", "recursos de aprendizaje", "organización del grado académico", "comunidad de aprendizaje", "cualidades del graduado" y "motivación intelectual". Desde el año 2002 se empezaron a utilizar, junto con las otras escalas que se aplicaban desde el año 1993, en procesos de aseguramiento de la calidad. Los resultados obtenidos de este proceso son publicados en la Guía de Buenas Universidades, por lo que afectan la imagen y la credibilidad de las instituciones de educación superior. También es importante destacar que el gobierno australiano mantiene un Fondo para el Rendimiento en Aprendizaje y Docencia, a través del cual entrega recursos a las universidades (Harris & James, 2010). Parte de las escalas del CEQ son usadas como evidencia para obtener recursos de este fondo.

Si bien el Course Experience Questionnaire ha tenido un rol clave en procesos de aseguramiento de la calidad, también se ha empleado con fines de investigación. En esta dirección se ha empleado para indagar en las percepciones de los estudiantes que se encuentran matriculados en el sistema de educación superior (P. Ginns, Prosser & Barrie, 2007). Por ejemplo, en situaciones pedagógicas especificas (Richardson, 2010), en investigaciones sobre innovaciones pedagógicas (Ellis & Goodyear, 2010), en evaluación de la calidad al interior de distintos departamentos (Diseth, Pallesen, Brunborg, & Larsen, 2010), en situaciones como educación a distancia (Richardson, 2005b) e incluso como insumo para procesos de aseguramiento de la calidad en países como Hong Kong (Webster, Chan, Prosser, & Watkins, 2009). También se han generado nuevos desarrollos para indagar elementos emergentes en la experiencia de aprendizaje de los estudiantes, como el progresivo uso de e-learning en instituciones de educación superior. Recientemente Ginns y Ellis (2009) desarrollaron una nueva escala sobre este aspecto; sin embargo, no ha sido aún incorporada al cuestionario oficial.

Es importante destacar que el CEQ es parte integral del modelo que se emplea en esta investigación (Student Learning Research) que, como se ha explicitado anteriormente, establece que la manera como los estudiantes aprenden está relacionada con la forma en que perciben la situación de aprendizaje en que se encuentran. Esto, además, permite afirmar que el CEQ es distinto de otros cuestionarios usados para evaluar cómo los estudiantes perciben sus entornos de aprendizaje. Está directamente relacionado con una teoría pedagógica y no con medidas de satisfacción asociadas a la teoría del consumidor (como, por ejemplo, el "Noel-Levitz Student Satisfaction Inventory" aplicado en Estados Unidos, Bryant, 2006; Richardson, 2005a). En este sentido es una potente herramienta para mejorar la calidad de la experiencia de aprendizaje de los estudiantes: tanto a los profesores universitarios como a los encargados de docencia entrega evidencia que, bien empleada, puede ayudar a mejorar los procesos que afectan el aprendizaje.

A pesar de estas posibilidades, en el contexto latinoamericano solo hemos encontrado un artículo académico que usa el CEQ para levantar información sobre las percepciones de los estudiantes. Fue realizado por Ruiz y Shumacher (2008) en la Escuela de Ciencias Humanas de la Universidad del Rosario en Bogotá, Colombia. Lamentablemente, el trabajo de estos autores emplea el CEQ sin informar los procesos de validación mínimos necesarios (traducción, back translation, análisis de validez y confiabilidad) para un instrumento construido en otro idioma y otro contexto cultural. Diversos investigadores han insistido largamente que no se deberían usar instrumentos en contextos culturalmente diferentes sin realizar estos procesos (por ejemplo, Brislin, 1986; Webster, et al., 2009). El trabajo de Ruiz y Shumacher, si bien es importante al introducir el CEQ y la línea de investigación Student Learning Research en el contexto latinoamericano, pierde credibilidad al no reportar si se realizó algún tipo de validación. Por lo tanto, el presente artículo apunta, precisamente, a presentar resultados iniciales de un proceso de validación del CEQ en un contexto distinto al cual fue originalmente desarrollado.

Metodología

Instrumento

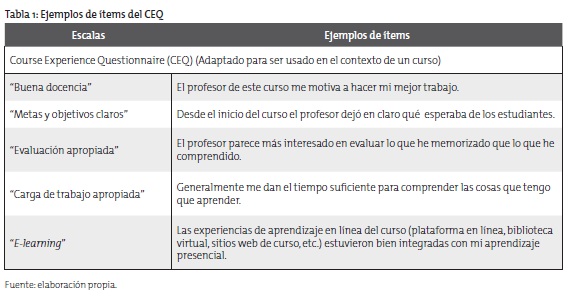

En el estudio que aquí se reporta se emplea la versión usada por Webster y sus colegas (2009) para validar el cuestionario con estudiantes de Hong Kong. Esta es una versión corta (17 items) que incluye las escalas "buena docencia", "metas y objetivos claros", "evaluación apropiada" y "carga de trabajo apropiada" Además, se incluyó la nueva escala desarrollada por Ginns y Ellis (2009) sobre e-learning. El número total de items con que se trabajó es 22. Es importante mencionar que el CEQ es un instrumento típicamente usado para evaluar la totalidad de la experiencia de aprendizaje de estudiantes universitarios al final de un grado académico completo. Si bien este es un uso que no ha sido considerado en países latinoamericanos -hasta donde se sabe-, eventualmente podría tomarse en cuenta como un indicador de calidad de la docencia de la manera en que se emplea en el contexto australiano. Sin embargo, para el caso de este proceso de validación, se optó por hacer referencia a un curso específico y no a un programa de pregrado finalizado. La razón de esta decisión es que se quiere validar el instrumento con fines de investigación más que con fines de aseguramiento de la calidad, así en esta versión cada ítem se refiere a un curso específico. La tabla 1 muestra ejemplos de los ítems de las escalas del CEQ utilizadas en este estudio.

Traducción

La versión en español de este instrumento fue traducida usando el siguiente método:

El cuestionario en su totalidad fue traducido al español por los investigadores participantes en el estudio.

Por medio de la técnica del procedimiento "back translation" (Brislin, 1986) fue nuevamente traducido al idioma inglés por una persona de habla nativa de un país anglosajón, a quien se le entregó la versión preliminar del instrumento en español.

Una vez obtenido el resultado de dicha traducción se procedió a comparar con la versión original en idioma inglés y se apreció que ambas eran bastante similares entre sí.

Finalmente se llevó a cabo un análisis de juicio de tres expertos para efectos de validez del contenido.

Muestra

El presente estudio se llevó a cabo con una muestra intencionada (Neuman, 2006) que consideró 325 estudiantes de ingeniería de una universidad pública, compleja y con foco en enseñanza e investigación de la región metropolitana de Chile.

Análisis

El análisis partió por estimar estadísticos descriptivos que incluyen, para cada ítem, promedio, desviación estándar y porcentajes de respuestas. Luego, se estimó la confiabilidad a través del cálculo del Alfa de Cronbach para cada una de las escalas del instrumento. En tercer lugar, para estimar la validez de constructo, se realizó un análisis de componentes principales con rotación Varimax, manteniéndose los valores sobre .3. Finalmente, para analizar la validez concurrente se procedió a correlacionar los resultados del CEQ con los resultados del cuestionario Study Process Questionnaire (SPQ), que se emplea para indagar cómo los estudiantes universitarios abordan el aprendizaje (Biggs, Kember, & Leung, 2001). Este cuestionario está compuesto por las escalas: "aprendizaje superficial" y "aprendizaje profundo" y de él existía una versión traducida y validada previamente (Recio Saucedo & Cabrero Almenara, 2005), que fue la que se utilizó en este estudio.

Resultados

Estadísticos descriptivos

En esta sección se presentan estadísticos descriptivos para cada uno de los items del CEQ. La tabla 2 presenta el promedio, desviación estándar y porcentajes de respuestas para los items de la escala "buena docencia".

La mayoría de los items de esta escala presentaron moderados niveles "de acuerdo", en torno al 50%. La excepción es el item "El profesor emplea mucho tiempo para comentar mi trabajo", respecto del cual el nivel "de acuerdo" es bajo. La tabla 3 presenta los estadísticos descriptivos para la escala "evaluación apropiada".

En este caso los tres ítems presentan bajos niveles "de acuerdo". Todos los ítems se encuentran bajo el 20%, siendo el ítem "El profesor sólo me hace preguntas literales de la materia" el que presenta el porcentaje más bajo "de acuerdo" en sus respuestas. La tabla 4 presenta los estadísticos descriptivos para la escala "carga de trabajo apropiada".

En general los porcentajes de respuestas "de acuerdo" están alrededor del 45% para los cuatro ítems que componen esta escala. El ítem "La carga de trabajo es muy pesada" es el que presenta el porcentaje "de acuerdo" más alto. La tabla 5 presenta los estadísticos descriptivos para la escala "metas y objetivos claros".

En esta escala en que los porcentajes de respuestas positivas no son homogéneos, el ítem que presenta el mayor porcentaje de respuestas "de acuerdo" es "Desde el inicio del curso el profesor dejó en claro qué se esperaba de los estudiantes". La tabla 6 presenta los estadísticos descriptivos para la escala "e-learning".

En la escala "e-learning" aparece un ítem con un alto porcentaje "de acuerdo". Este es: "Los recursos de la página web de mi universidad (plataforma en línea, biblioteca, sitios web de curso, etc.) apoyaron mi aprendizaje". Los otros cuatro ítems, sin embargo, representan porcentajes de respuestas en la categoría "de acuerdo" en torno al 30%.

Análisis de contabilidad

La tabla 7 muestra los resultados del análisis de confiabilidad.

Según los criterios establecidos por DeVellis (2003), los resultados muestran que la escala "buena docencia" presenta un valor muy bueno, las escalas "evaluación apropiada" y "e-learning" presentan valores buenos, la escala "metas y objetivos claros" presenta un valor aceptable y la escala "carga de trabajo apropiada" presenta un valor por debajo del mínimo considerado como aceptable.

Análisis factorial de componentes principales

La estimación de la validez de constructo del instrumento se llevó a cabo a través de un análisis factorial de componentes principales que se presenta en la tabla 8. En los resultados de la prueba de KMO se obtuvo un valor muy bueno (KMO=.84), lo cual indica una buena adecuación de los datos a un modelo factorial. Por otro lado, el resultado de la prueba de Barlett es estadísticamente significativo (X2= 2070.027; p= .000) (Hair, 1998; Thompson, 2004).

Los resultados del análisis de componentes principales muestran claramente que los factores corresponden a las escalas del cuestionario CEQ. Sin embargo, los ítems "En este curso, usualmente he tenido una idea clara hacia dónde vamos y qué se espera de mí", "Desde el inicio del curso el profesor dejó en claro qué se esperaba de los estudiantes", "El profesor parece más interesado en evaluar lo que he memorizado que lo que he comprendido" y "Generalmente me dan el tiempo suficiente para comprender las cosas que tengo que aprender" presentaron cargas cruzadas mayores a .3 en la escala "buena docencia".

Análisis de validez concurrente

Los resultados, presentados en la tabla 9 muestran que las escalas "buena docencia", "metas y objetivos claros", "evaluación apropiada" y "carga de trabajo apropiada" presentan correlaciones negativas y significativas con la escala "aprendizaje superficial". La correlación entre esta escala y la de "e-learning" no es significativa, aunque tiene la misma dirección que las otras. Por otro lado, las escalas "buena docencia", "metas y objetivos claros", "evaluación apropiada" y "e-learning" presentan correlaciones positivas y significativas con la escala "aprendizaje profundo'. La correlación entre "carga de trabajo apropiada" y "enfoque profundo" no es significativa pero tiene la misma dirección que las correlaciones entre las otras escalas.

Discusión

Los resultados presentados son relevantes y permiten afirmar, preliminarmente, que el CEQ podría emplearse como un indicador de calidad de la experiencia de aprendizaje, útil para realizar investigación en esta área. En primer lugar los valores del Alfa de Cronbach fueron muy buenos para la escala "buena docencia" y aceptable para la escala "evaluación apropiada", lo que está en línea con los valores reportados en otros estudios (véase por ejemplo, P. Ginns, et al., 2007; Webster, et al., 2009). En relación con la escala "e-learning" se presentó un valor similar al reportado por Ginns & Ellis (2009). Por otro lado, las escalas "metas y objetivos claros" y "carga de trabajo apropiada" presentaron valores relativamente inferiores a los reportados en estudios previos. La escala "carga de trabajo apropiada", por presentar un valor menor que el aceptable, deberá ser considerada con atención en futuros procesos de validación.

En segundo lugar, el análisis de validez de constructo mostró que las escalas emergían como se había hipotetizado y que la escala "e-learning" también se comportaba de manera adecuada cuando se la incorporaba al instrumento. Sin embargo, cuatro ítems presentaron cargas cruzadas mayores al puntaje de corte (.3). Estos ítems fueron "En este curso, usualmente he tenido una idea clara hacia dónde vamos y qué se espera de mí", "Desde el inicio del curso el profesor dejó en claro qué se esperaba de los estudiantes", "Generalmente me dan el tiempo suficiente para comprender las cosas que tengo que aprender" y "El profesor parece más interesado en evaluar lo que he memorizado que lo que he comprendido". Es importante mencionar que los tres primeros ítems presentaron resultados similares (cargas cruzadas superiores a .3) en el estudio de validación realizado en Hong Kong por Webster y colegas (2009). Por otro lado, también es importante tener en consideración que, a partir de los resultados del presente estudio, no se verificaron cargas cruzadas o estructuras diferentes como las reportadas en otros artículos académicos. Por ejemplo, ítems de la escala "buena docencia" cargando en la escala "evaluación apropiada" (Wilson, et al., 1997), o el estudio de Kreber (2003) en el que la escala "buena docencia" se separó en dos factores.

En tercer lugar, los resultados del análisis de validez concurrente son coherentes con investigaciones en el área que reportan que cuando los estudiantes perciben positivamente su contexto de aprendizaje tienden a abordar su aprendizaje de manera profunda, y que cuando lo perciben negativamente lo abordan de manera superficial. Este hallazgo ha sido replicado en varios estudios y también aparece en la investigación aquí reportada (véase por ejemplo, Diseth, 2007; Diseth, et al., 2010; Ellis & Goodyear, 2010; Ellis, Goodyear, Calvo, et al., 2008; P. Ginns, et al., 2007; Leung, Ginns & Kember, 2008; Richardson, 2010).

Estos resultados tienen implicaciones para el futuro desarrollo de actividades de investigación en esta área. En primer lugar, es importante mencionar que los resultados son auspiciadores y por lo tanto es razonable continuar explorando las potencialidades y el uso del CEQ. Es importante, por ejemplo, levantar datos para explorar el tipo de resultados que se puede obtener con estudiantes de otras áreas disciplinarias. Además, es clave indagar cómo se comporta el modelo Student Learning Research en el contexto latinoamericano.

Como se estableció al inicio de este artículo, cuando los profesores enseñan centrándose en el aprendizaje los estudiantes tienden a abordar sus estudios de manera profunda y a obtener mejores resultados académicos. Para investigar esto se necesita tener traducidos y validados los cuestionarios empleados para explorar las asociaciones entre la experiencia de aprendizaje de profesores y estudiantes, uno de los cuales es el CEQ. Por lo tanto, contar con este instrumento traducido y validado permitiría indagar si el hallazgo central de la línea de investigación con que trabajamos es consistente con estudiantes latinoamericanos. Si lo fuera, posibilitaría alinear el desarrollo y liderazgo en temas de docencia de manera coherente con los resultados del Student Learning Research. Esto beneficiaría enormemente a las universidades, pues contarían con un modelo testeado y validado con implicaciones claras para la docencia. En el presente nuestro trabajo se orienta a materializar este objetivo.

Conclusión

En este artículo se presentaron los resultados de una indagación preliminar sobre la validez y confiabilidad del Course Experience Questionnaire (CEQ), realizada con una muestra de estudiantes de ingeniería de una universidad pública metropolitana de Chile. Los resultados indicaron buenos valores de confiabilidad para todas las escalas, salvo para la de "carga de trabajo apropiada". Por otro lado, la estructura de factores emergió como se había hipotetizado y el análisis de validez concurrente fue coherente con estudios reportados previamente. Estos resultados permiten establecer que, en principio, el CEQ podría emplearse como un indicador de calidad de la docencia en el contexto de universidades latinoamericanas y ser empleado con fines de investigación. Nuevas investigaciones deberán continuar el proceso de validación e incorporar otras variables consideradas clave por la línea Student Learning Research para indagar la experiencia de aprendizaje de los estudiantes universitarios.

Bibliografía

Biggs, J., Kember, D. & Leung, D. Y. P. (2001). The revised two-factor Study Process Questionnaire: R-SPQ-2F. British Journal of Educational Psychology, 71, 133-149.

Biggs, J. & Tang, C. (2007). Teaching for quality learning at university : what the student does (3nd ed.). Phildelphia, Pa.: Society for Research into Higher Education: Open University Press.

Brislin, R. (1986). The wording and translation of research instruments. In W. J. Lonner & J. W. Berry (Eds.), Field methods in cross-cultural research (pp. 137-164). Beverly Hills, CA: SAGE.

Bryant, J. L. (2006). Assessing expectations and perceptions of the campus experience: The Noel-Levitz Student Satisfaction Inventory. New Directions for Community Colleges, 2006 (134), 25-35.

DeVellis, R. F. (2003). Scale development: theory and applications (2nd ed.). Thousand Oaks, Calif.: Sage Publications, Inc.

Diseth, A. (2007). Approaches to learning, course experience and examination grade among undergraduate psychology students: testing of mediator effects and construct validity. Studies in Higher Education, 32 (3), 373 - 388.

Diseth, A., Pallesen, S., Brunborg, G. S. & Larsen, S. (2010). Academic achievement among first semester undergraduate psychology students: the role of course experience, effort, motives and learning strategies. Higher Education, 59 (3), 335-352.

Ellis, R. & Goodyear, P. (2010). Students' experiences of e-learning in higher education. The ecology of sustainable innovation. New York & London: Routledge.

Ellis, R., Goodyear, P., Brillant, M. & Prosser, M. (2008). Student experiences of problem-based learning in pharmacy: conceptions of learning, approaches to learning and the integration of face-to-face and on-line activities. Advances in Health Sciences Education, 13 (5), 675-692.

Ellis, R., Goodyear, P., Calvo, R. A. & Prosser, M. (2008). Engineering students' conceptions of and approaches to learning through discussions in face-to-face and online contexts. Learning and Instruction, 18 (3), 267-282.

Entwistle, N. (2007). Research into student learning and university teaching. BJEP Monograph Series II, Number 4 - Student Learning and University Teaching, 1, 1-18.

Ginns, P. & Ellis, R. A. (2009). Evaluating the quality of e-learning at the degree level in the student experience of blended learning. British Journal of Educational Technology, 40 (4), 652-663.

Ginns, P., Kitay, J. & Prosser, M. (2008). Developing conceptions of teaching and the scholarship of teaching through a Graduate Certificate in Higher Education. The International Journal for Academic Development, 13, 175-185.

Ginns, P., Prosser, M. & Barrie, S. (2007). Students' perceptions of teaching quality in higher education: the perspective of currently enrolled students. Studies in Higher Education, 32 (5), 603-615.

González, C. (2010). Investigación sobre el aprendizaje y conocimiento académico sobre la enseñanza como claves para mejorar la docencia universitaria. Calidad en la Educación, 33 (2do semestre ), 126 - 143. Disponible en: http://www.cned.cl/public/secciones/SeccionRevistaCalidad/doc/168/cse_resumen959.pdf [Fecha de consulta: 24 de agosto de 2010].

González, C. (2011). Extending research on 'conceptions of teaching': commonalities and differences in recent investigations. Teaching in Higher Education, 16 (1), 65 - 80.

Harris, K.-L. & James, R. (2010). The Course Experience Questionnaire, Graduate Destination Survey, and Learning and Teaching Performance Fund in Australia. In D. D. Dill & M. Beerkens (Eds.), Public Policy for Academic Quality (Vol. 30, pp. 99-119): Springer Netherlands.

Kember, D. (1997). A reconceptualisation of the research into university academics' conceptions of teaching. Learning and Instruction, 7 (3), 255-275.

Kreber, C. (2003). The relationship between students' course perception and their approaches to studying in undergraduate science courses: A Canadian experience. Higher Education Research and Development, 22 (1), 57 - 75.

Leung, D. Y. P., Ginns, P. & Kember, D. (2008). Examining the cultural specificity of approaches to learning in universities in Hong Kong and Sydney. Journal of Cross-Cultural Psychology, 39 (3), 251-266.

Lingard, J., Minasian-Batmanian, L., Vella, G., Cathers, I. & González, C. (2009). Do students with well-aligned perceptions of question difficulty perform better? Assessment & Evaluation in Higher Education, 34 (603-619).

Marton, F. & Saljo, R. (2005). Approaches to learning In F. Marton, D. Hounsell & N. J. Entwistle (Eds.), The experience of learning: implications for teaching and studying in higher education. 3rd (Internet) edition. Edinburgh: University of Edinburgh, Centre for Teaching, Learning and Assesment.

McInnis, C., Griffin, P., James, R. & Coates, H. (2001). Development of the Course Experience Questionnaire (CEQ). Canberra: Department of Education, Training and Youth Affairs.

Minasian-Batmanian, L. C., Lingard, J. & Prosser, M. (2006). Variation in student reflections on their conceptions of and approaches to learning biochemistry in a first-year health sciences' service subject. International Journal of Science Education, 28 (15), 1887-1904.

Neuman, W. L. (2006). Social research methods: qualitative and quantitative approaches (6th ed.). Boston: Pearson/Allyn and Bacon.

Postareff, L., & Lindblom-Ylánne, S. (2008). Variation in teachers' descriptions of teaching: Broadening the understanding of teaching in higher education. Learning and Instruction, 18 (2), 109-120.

Prosser, M. & Trigwell, K. (1999). Understanding learning and teaching: the experience in higher education. Buckingham [England]; Philadelphia, PA: Society for Research into Higher Education & Open University Press.

Prosser, M. & Trigwell, K. (2006). Confirmatory factor analysis of the approaches to teaching inventory. British Journal of Educational Psychology, 76, 405-419.

Ramsden, P. (1991). A performance indicator of teaching quality in higher education: the 'Course Experience Questionnaire'. Studies in Higher Education, 16, 129-150.

Ramsden, P. & Entwistle, A. (1981). Effects of academic departments on students' approaches to studying. British Journal of Educational Psychology, 51, 368-383.

Recio Saucedo, M. & Cabrero Almenara, J. (2005). Enfoques de aprendizaje, rendimiento académico y satisfacción de los alumnos en formación en entornos virtuales. Revista de Medios y Educación, 25, 93-115.

Richardson, J. T. E. (2005a). Instruments for obtaining student feedback: a review of the literature. Assessment & Evaluation in Higher Education, 30 (4), 387 - 415.

Richardson, J. T. E. (2005b). Students' perceptions of academic quality and approaches to studying in distance education. British Educational Research Journal, 31 (1), 7-27.

Richardson, J. T. E. (2009). What can students' perceptions of academic quality tell us? research using the course experience questionnaire. In M. Tight, K. H. Mok, J. Huisman & C. Morphew (Eds.), The Routledge International Handbook of Higher Education (pp. 199-209). London; New York: Routledge.

Richardson, J. T. E. (2010). Perceived Academic Quality and Approaches to Studying in Higher Education: Evidence from Danish Students of Occupational Therapy. Scandinavian Journal of Educational Research, 54 (2), 189-203.

Ruiz, F. A. & Schumacher, C. (2008). Evaluación del aprendizaje universitario. Educación y Educadores, 11, 91-105.

Trigwell, K. & Ashwin, P. (2006). An exploratory study of situated conceptions of learning and learning environments. Higher Education, 51 (2), 243-258.

Trigwell, K., Prosser, M. & Waterhouse, F. (1999). Relations between teachers' approaches to teaching and students' approaches to learning. Higher Education, 37 (1), 57-70.

Webster, B. J., Chan, W. S. C., Prosser, M. T. & Watkins, D. A. (2009). Undergraduates' learning experience and learning process: quantitative evidence from the East. Higher Education, 58 (3), 375-386.

Wilson, K. L., Lizzio, A. & Ramsden, P. (1997). The development, validation and application of the course experience questionnaire. Studies in Higher Education, 22 (1), 33-53